現実世界における『シモーヌ』的技術

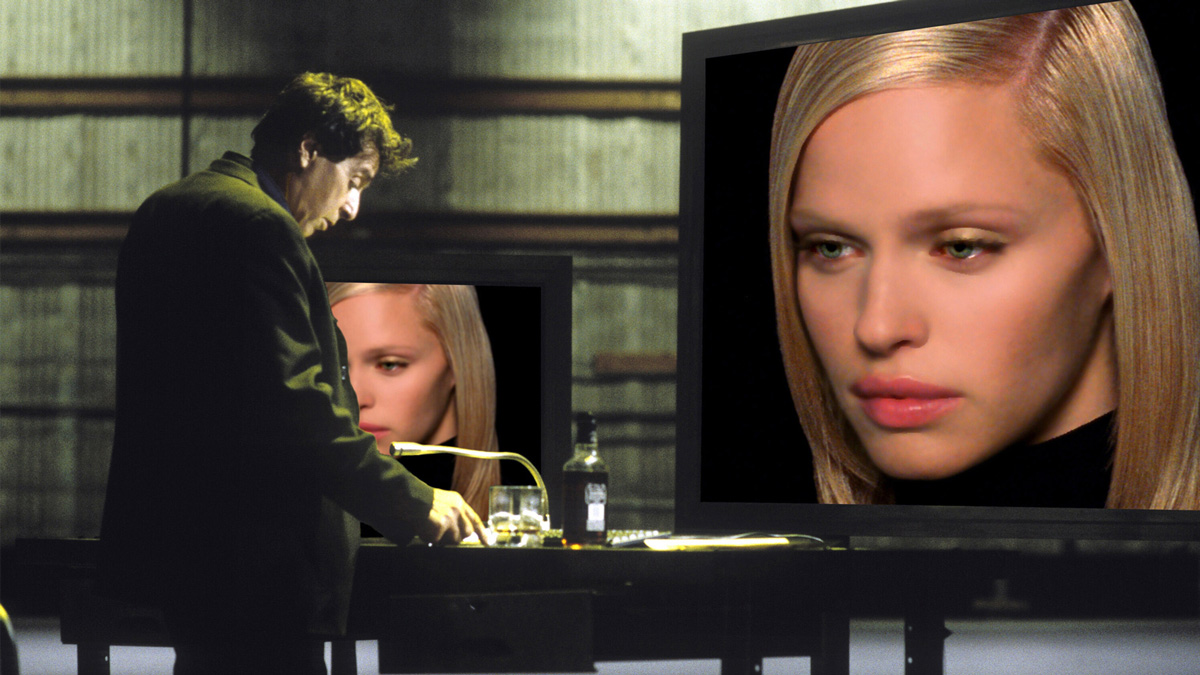

劇中でタランスキーは、リアルタイムで自分の声をシモーヌのものに変換している。これは単純なボイスチェンジャーではなく、俳優のデータベースを学習させ、選び出した特徴をブレンドさせて作った声だ。発音のニュアンスも、いかにもシモーヌという“架空の人格”が話しているかのようになっている。

実は、これと似たテクノロジーはすでに存在しており、例えば23年にリリースされた「RVC」(Retrieval-based Voice Conversion)という音声変換技術は、わずか10分間程度の音声データさえあれば、話者の声の特徴を学習してしまい、イントネーションや感情表現を保持しながら別の声色に変換できる。この技術があれば、劇中でタランスキーが行っているように、映画のセリフなどから学習させた音声を自分の声と変換させ、インタビューなどに回答していくことも可能だ。

また日本国内でも24年に、NTTが深層学習に基づくリアルタイム音声変換技術を発表している。これは、わずか数十ミリ秒レベルの低遅延で、話者の声を高音質で別人の声に変換できるテクノロジーだ。

またタランスキーがやっている、マーカーレス・モーションキャプチャーも、現在ならAIを活用することで可能になっている。この映画が制作された当時も、モーションキャプチャーのシステムは存在していた。しかし、多数の赤外線カメラを並べた“ボリューム”と呼ばれる専用スタジオと、全身に再帰性反射マーカーを付けたスーツの着用が必要だった。それでも、目の動きを含めた表情のキャプチャーは不可能で、これは『アバター』(09)におけるヘッドマウントカメラ(https://cinemore.jp/jp/erudition/2775/article_2776_p2.html#a2776_p2_1)の開発を待つ必要があった。

しかし現在なら、Autodesk社の「Markerless AI Motion Capture」を用いれば、スマホやWebカメラの映像から、AIが骨格ポイントを自動抽出して3Dモーションデータへ変換してくれる。これならばマーカーやボリュームは不要で、さらにフェイシャルキャプチャーにも対応する。

一方で、カメラの画角に入っていない動きは正確に取得できなかったり、リアルタイム処理には対応できないなどの問題も残っており、まだ商用利用には複数の専用カメラを用いる「Vicon Markerless」などの方に分がある。

フェイシャルキャプチャーのソフトウェアに関しては、『アバター:ウェイ・オブ・ウォーター』(22)や『アバター:ファイヤー・アンド・アッシュ』(25)のために、Wētā FX社がAIを用いたフェイシャル・ソルバーのFDLS(Facial Deep Learning Solver)を開発している。

もしこれに似たものを、タランスキーが使用していたと仮定すれば、自分の演技を反映させたシモーヌの表情を見ながら、さらにマイクロ・エクスプレッション(微表情)レベルでチューニングを行っただろう。そして、シモーヌに独自のクセを学習させることで、ますます人間味に拍車がかかる。